像 GPT 一样训练自己:人类成长的“RLHF”法则

你有没有想过一件事——

GPT-4o 为什么看起来越来越像“高智商的人”?

并不是它突然拥有了意识,也不是它生来就有“天赋”。

而是因为它不断汲取海量优质内容,这些内容来自世界上最聪明的大脑。

这让我不禁意识到:

人类的成长方式,其实和训练一个大模型惊人相似。

01 GPT 靠什么变聪明?

OpenAI、Gemini 等背后的大模型之所以越训越强,有几点秘诀:

- 它们不刷八卦段子,不看无意义的碎片化信息。

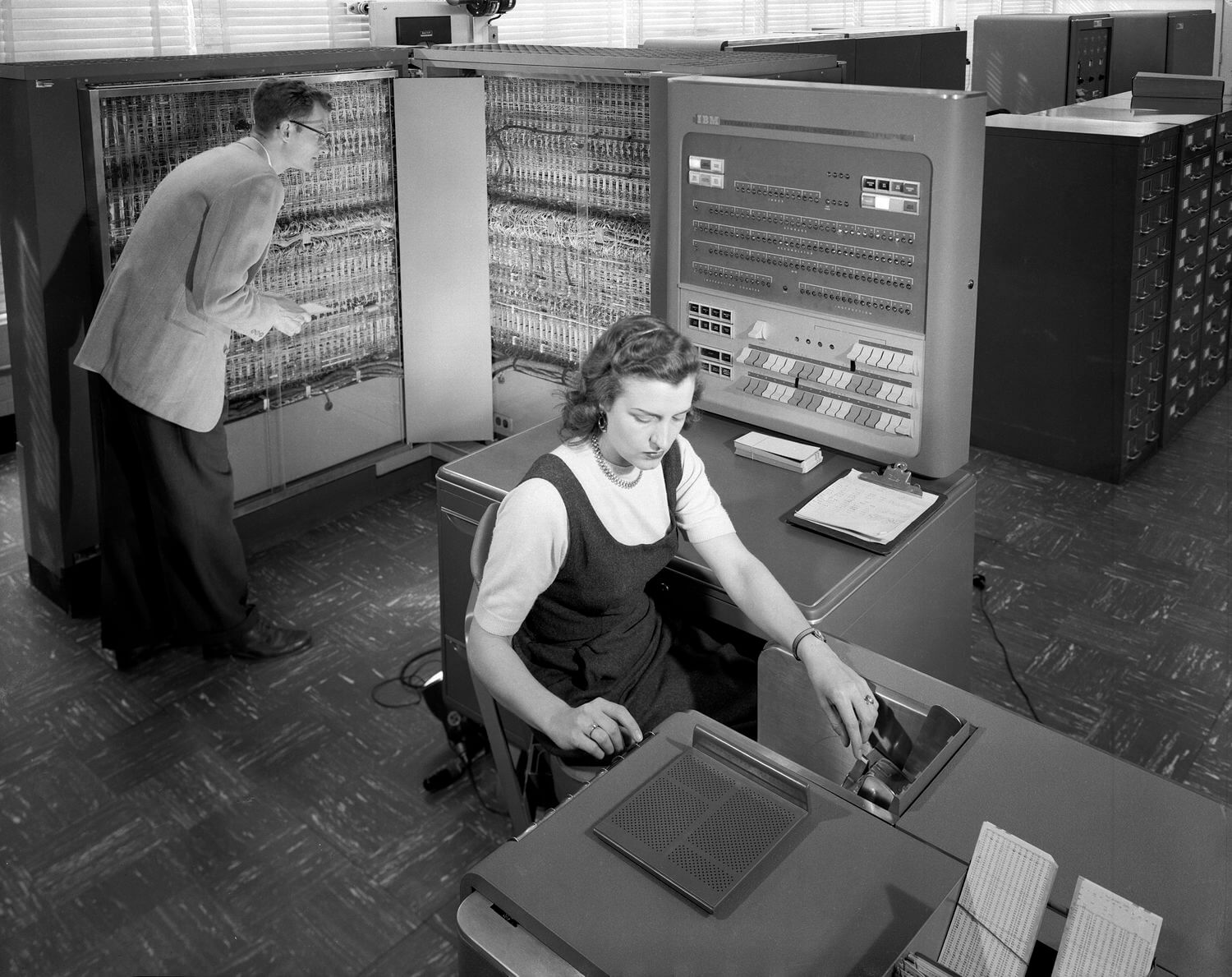

- 它们的训练数据来自上亿条“高质量”素材:开源代码、学术论文、经典著作、真实对话……

- 开发者甚至邀请神经科学家、生物学家、哲学家等专家协助“标注”,确保内容准确可靠。

它们学习的是人类最优秀的语言表达、严谨的思辨逻辑、深邃的知识体系。

而这些,恰恰也是我们自己变得更聪明的关键。

02 大脑的“训练数据”有多重要?

同样,你每天喂给大脑的“输入”,决定了你能成长为什么样的人。

- 如果你沉迷抖音、刷搞笑短片,那么你的大脑就像个只会讲段子的模型;

- 如果你听张潇雨解构思维、读吴军剖析底层逻辑、学经济学、精读经典著作,那么你训练出的,就是一个善于推理、表达、打通知识脉络的“思考引擎”。

我也不是天赋异禀的那位,但我早早领悟到一句话:

Learn from the best。

从 2016 年起,我就把吴军的技术周期、薛兆丰的制度经济学、张潇雨的结构化思维、刘润的商业进化论,统统当成自己大脑的“核心训练集”。

03 大多数人成长为什么慢?

并非因为他们懒惰,而是:

一开始就“喂错”了训练集。

短视频刺激大脑的多巴胺,却无助于长期复利;综艺满足情绪,却不助逻辑深度。

你以为自己在“休闲娱乐”,其实是在训练一个只能“走马观花”、无法沉淀观点的低效模型。

04 我的「认知飞轮」长什么样?

下面是我这套「人类版 RLHF」的训练路径:

- 输入阶段:只看顶尖内容(《得到》、极客时间、优质播客、前沿论文)

- 提炼阶段:不盲搬原文,结构化总结,构建自己的知识图谱

- 输出阶段:在 X 上发思想、写频道文章,强迫自己表达清晰

- 反馈阶段:通过社群互动和复盘,修正表达、填补理解盲区

这条闭环,看似和强化学习(Reinforcement Learning)+ 人类反馈(Human Feedback)如出一辙;但它并非死记硬背,而是有意识地「训练自己」。

05 最后一点感悟

GPT 用海量 Token 变强,

我们则要用洞察力不断升级。

每天都在给自己「刷数据」,

只是大多数人还没意识到,

自己早已在无声无息中,

成为了自己大脑的「训练模型」。

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来自 既往不恋!

评论

WalineGitalk